互信息

出自 MBA智库百科(https://wiki.mbalib.com/)

互信息(Mutual Information)

目录 |

一般而言,信道中总是存在着噪声和干扰,信源发出消息x,通过信道后信宿只可能收到由于干扰作用引起的某种变形的y。信宿收到y后推测信源发出x的概率,这一过程可由后验概率p(x|y)来描述。相应地,信源发出x的概率p(x)称为先验概率。我们定义x的后验概率与先验概率比值的对数为y对x的互信息量,也称交互信息量(简称互信息)。

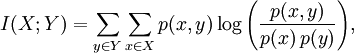

互信息是指信息论里一种有用的信息度量,它是指两个事件集合之间的相关性。两个事件X和Y的互信息定义为: 又可以表示成:

又可以表示成:

I(X;Y) = H(X) − H(X | Y)

= H(Y) − H(Y | X)

= H(X) + H(Y) − H(X,Y)

= H(X,Y) − H(X | Y) − H(Y | X)

其中H(X,Y)是联合熵(Joint Entropy),其定义为:

H(X|Y)是条件熵(conditional entropy),定义重属于熵的定义。

互信息是计算语言学模型分析的常用方法,它度量两个对象之间的相互性。在过滤问题中用于度量特征对于主题的区分度。互信息的定义与交叉熵近似。互信息本来是信息论中的一个概念,用于表示信息之间的关系, 是两个随机变量统计相关性的测度,使用互信息理论进行特征抽取是基于如下假设:在某个特定类别出现频率高,但在其他类别出现频率比较低的词条与该类的互信息比较大。通常用互信息作为特征词和类别之间的测度,如果特征词属于该类的话,它们的互信息量最大。由于该方法不需要对特征词和类别之间关系的性质作任何假设,因此非常适合于文本分类的特征和类别的配准工作。